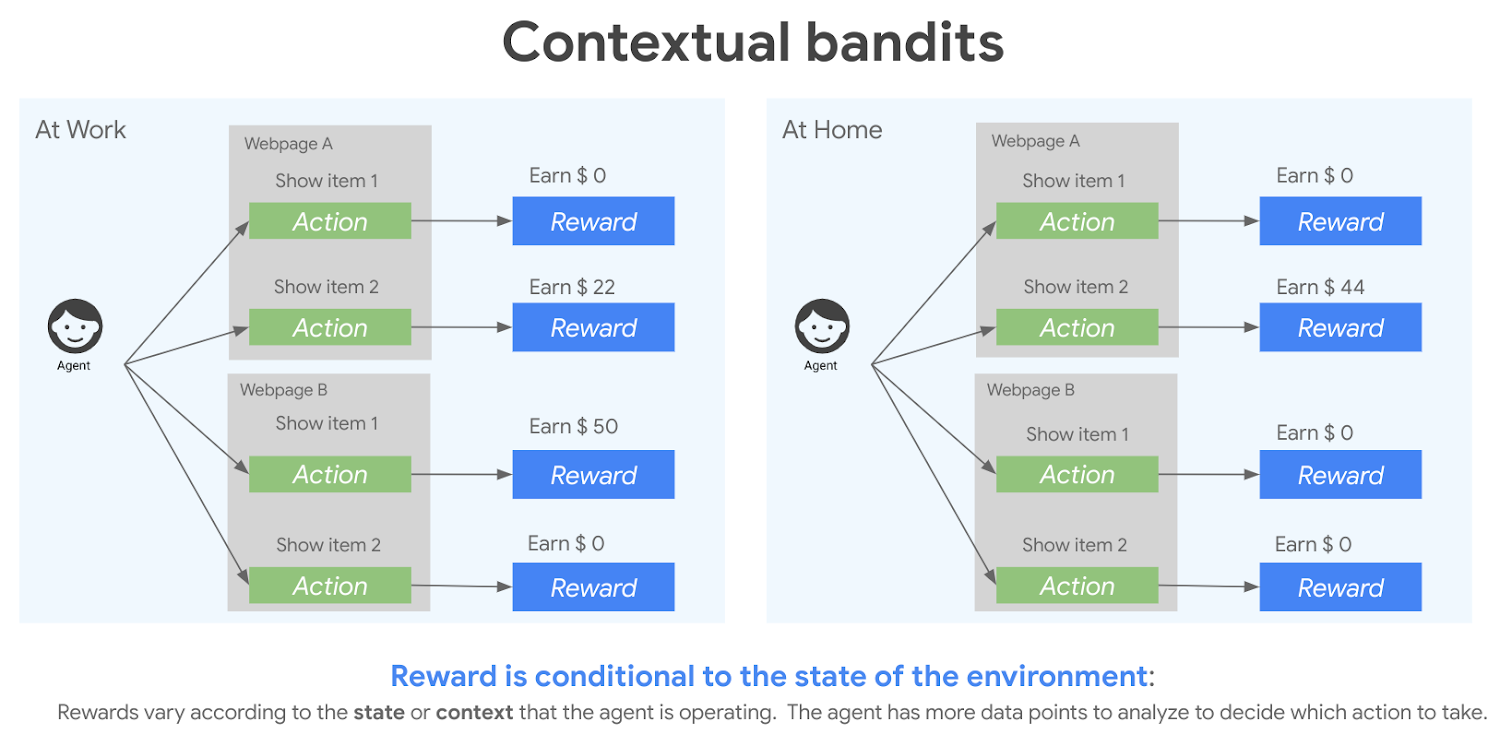

Contextual Armed Bandits

Como se relaciona com aprendizado por reforço?

Deep Racer

O que é aprendizado por reforço?

Agente | Ambiente

Estado | Ação

Recompensa, Função de

Retorno e objetivo

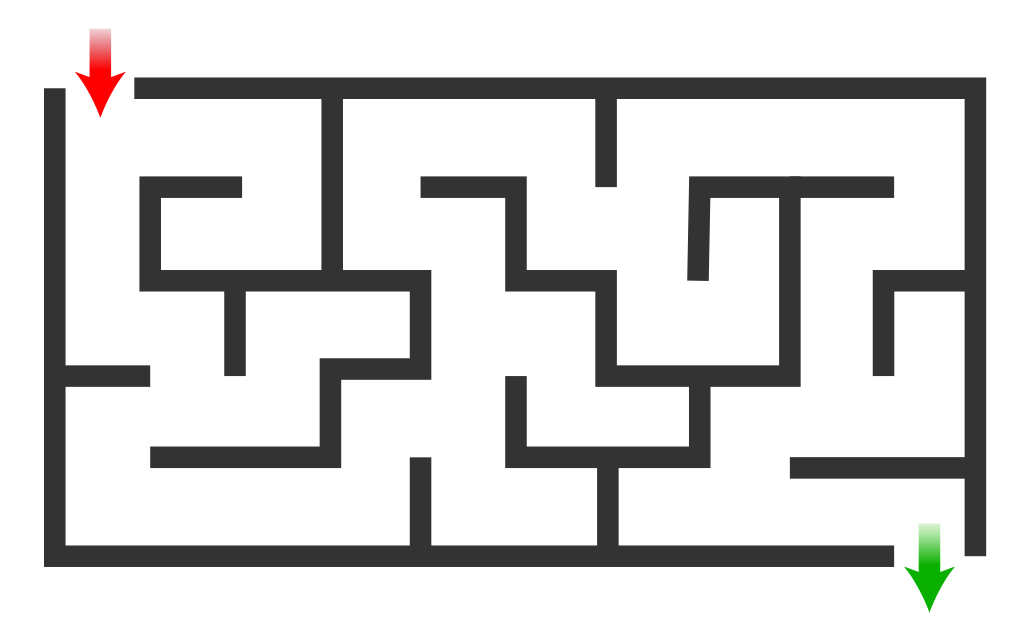

Como modelar o problema de sair do labirinto?

Mais um exemplo...

Função de recompensa no Deep Racer

Position on track

Heading

Waypoints

Track width

Distance from center line

All wheels on track

Speed

Steering angle

Exemplo:

def reward_function(params):

'''

Example of rewarding the agent to follow center line

'''

# Read input parameters

track_width = params['track_width']

distance_from_center = params['distance_from_center']

# Calculate 3 markers that are at varying distances away from the center line

marker_1 = 0.1 * track_width

marker_2 = 0.25 * track_width

marker_3 = 0.5 * track_width

# Give higher reward if the car is closer to center line and vice versa

if distance_from_center <= marker_1:

reward = 1.0

elif distance_from_center <= marker_2:

reward = 0.5

elif distance_from_center <= marker_3:

reward = 0.1

else:

reward = 1e-3 # likely crashed/ close to off track

return float(reward)

Parâmetros e Hiperparâmetros

Competição

- Competição individual por aluno.

- Inscrições a partir de 5 de março.

- Haverá 3 workshops virtuais.

- Corrida virtual classificatória.

- 5 modelos selecionados por região geográfica

- 25 finalistas no Congresso da SBC em Brasília.

Bibliografia complementar

- Sutton, R.S. and Barto, A.G. (2018) Reinforcement Learning: An Introduction. 2nd Edition, A Bradford Book, Cambridge. Capítulo 3 até a seção 3.3.

Para ir mais além

- J. Schulman, F. Wolski, P. Dhariwal, A. Radford, and O. Klimov, Proximal policy optimization algorithms, arXiv.org, arXiv:1707.06347 [cs.LG].

- Post de apresentação de resultados.