Faz sentido só investigar?

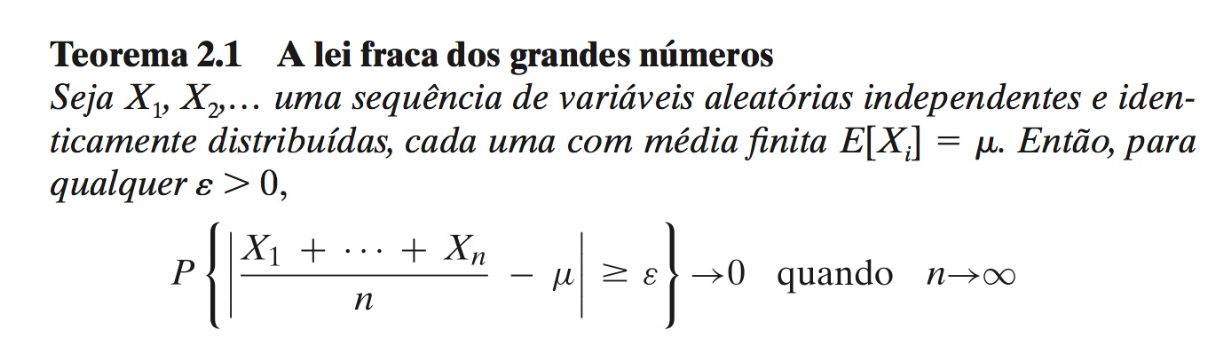

Lei dos grandes números

Faz sentido só explorar?

"SE EU TIVESSE 8 HORAS PARA CORTAR UMA ÁRVORE, GASTARIA SEIS AFIANDO MEU MACHADO"

-- Abraham Lincoln? Gimli, filho de Glóin? Desconhecido?

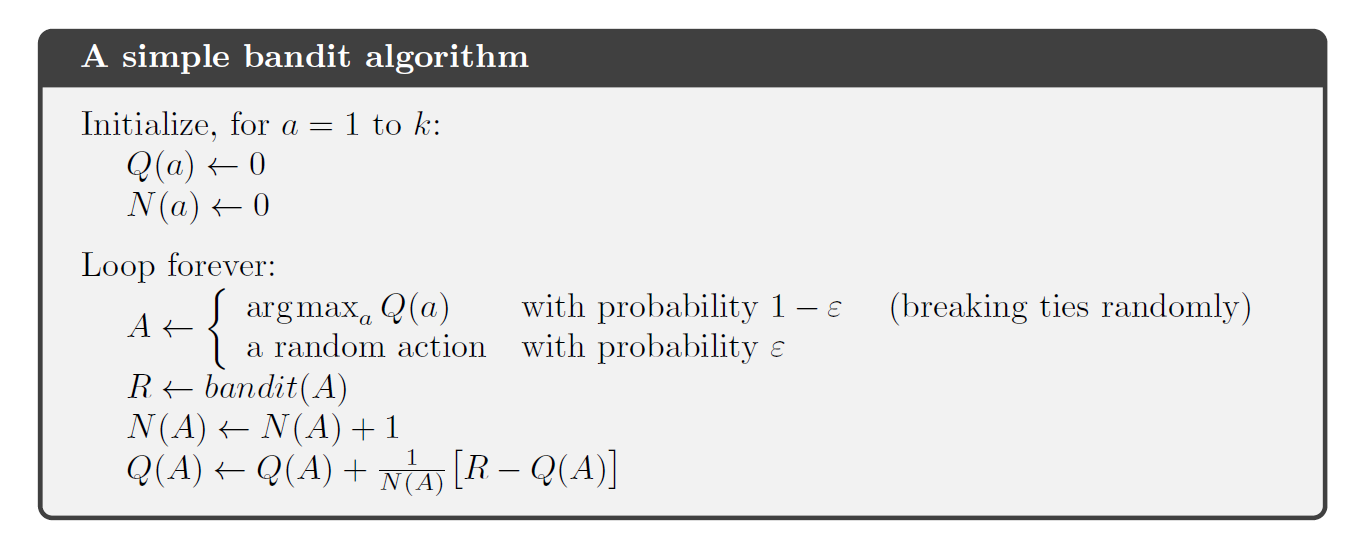

Como solucionar razoavelmente o problema de multi-armed bandits?

Métodos que avaliam ações

(action-value methods)

-

Valor de uma ação:

-

Estimativa do valor:

Que ação tomar?

Greedy vs

Ação escolhida com base no valor

- Aleatória

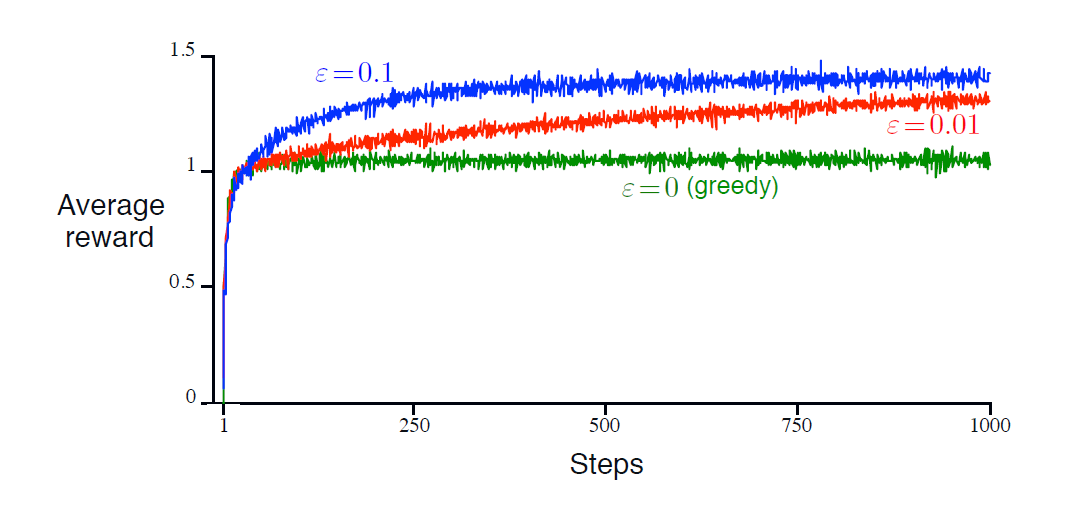

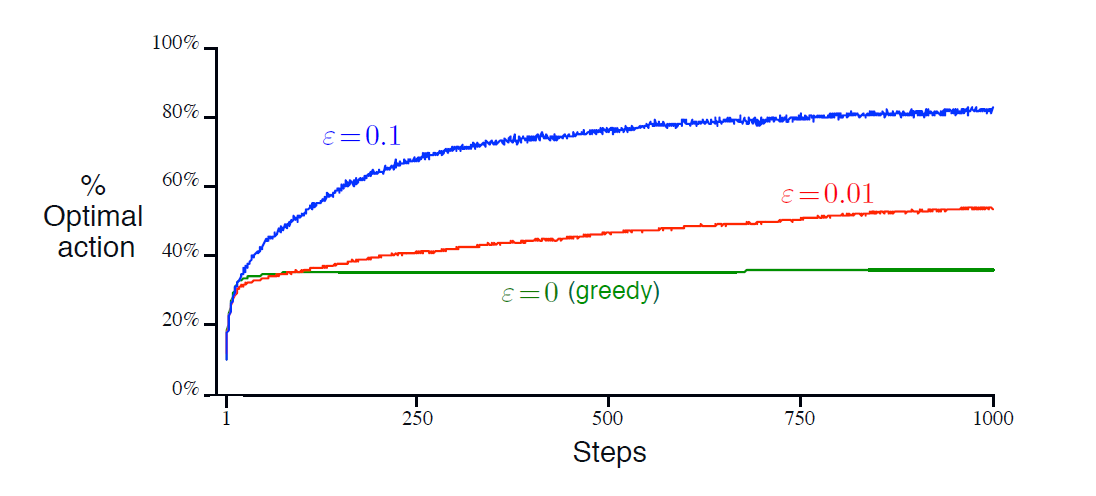

Exemplo:

10-armed testbed

Greedy vs

Greedy vs

Algoritmo

Como fazer um algoritmo greedy investigar mais?

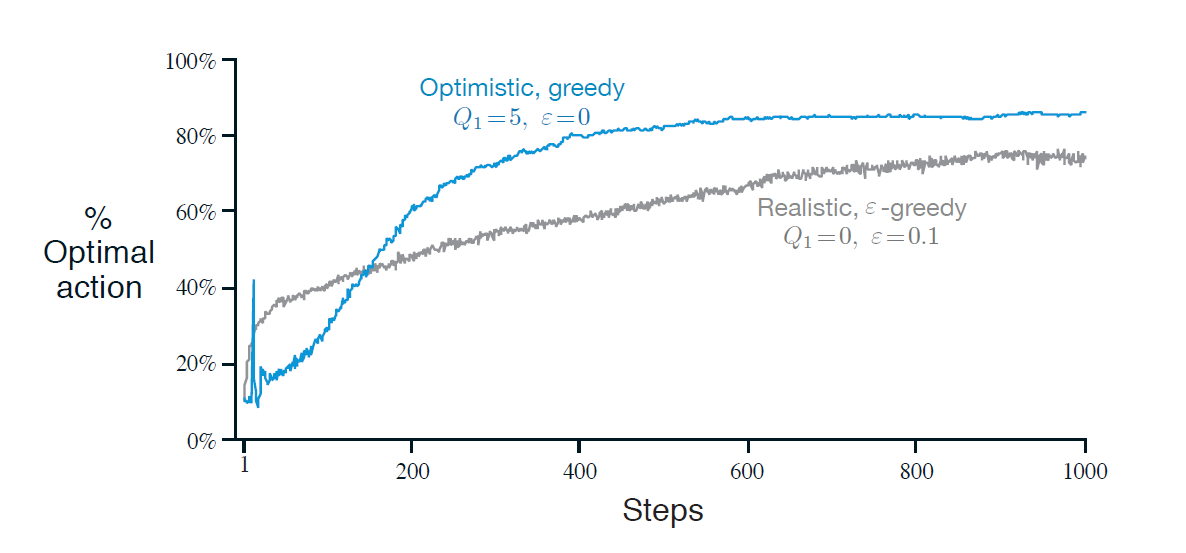

Escolhas iniciais otimistas

E se as distribuições não forem estacionárias?

Cálculo do valor de uma ação

Quando

Qualquer sequência

Como se relaciona com aprendizado por reforço?

Contextual Armed Bandits

<<< Próxima semana >>>

TROCA DE CONTEXTO

Problema do Cartpole

Bibliografia complementar

- Sutton, R.S. and Barto, A.G. (2018) Reinforcement Learning: An Introduction. 2nd Edition, A Bradford Book, Cambridge. Capítulo 2.

Para ir mais além

- A. G. Barto, R. S. Sutton and C. W. Anderson, "Neuronlike adaptive elements that can solve difficult learning control problems," in IEEE Transactions on Systems, Man, and Cybernetics, vol. SMC-13, no. 5, pp. 834-846, Sept.-Oct. 1983, doi: 10.1109/TSMC.1983.6313077.